El archivo robots.txt es un archivo de texto simple que se encuentra en la raíz de un sitio web y que se utiliza para comunicar a los robots de búsqueda qué páginas o archivos del sitio web pueden ser rastreados e indexados.

Este archivo juega un papel crucial en SEO al permitir a los webmasters controlar cómo los motores de búsqueda como Google o Bing interactúan con su sitio web.

¿Qué es el archivo robots.txt?

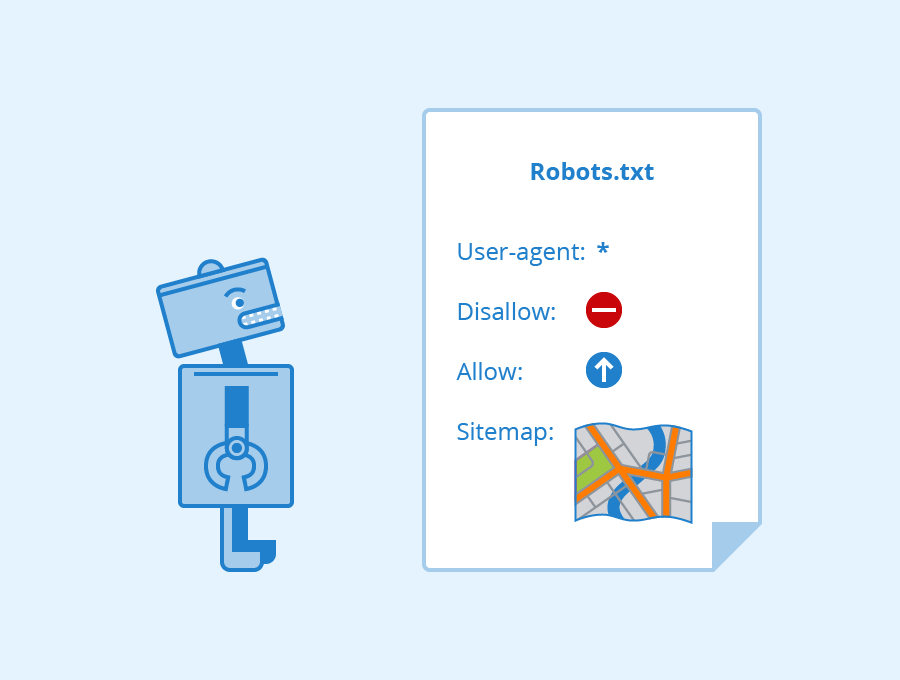

El archivo robots.txt es un archivo de texto plano que contiene una serie de instrucciones para los robots de búsqueda. Estas instrucciones se denominan “directivas” y se utilizan para indicar a los robots qué páginas o archivos pueden ser rastreados e indexados.

¿Cómo funciona el archivo robots.txt?

Los robots de búsqueda, como Googlebot, visitan regularmente los sitios web para descubrir nuevas páginas e indexarlas. Cuando un robot de búsqueda llega a un sitio web, busca el archivo robots.txt. Si el archivo existe, el robot lo lee y sigue las instrucciones que contiene.

Directivas comunes del archivo robots.txt:

- User-agent: Esta directiva se utiliza para especificar a qué robots de búsqueda se aplican las instrucciones.

- Allow: Esta directiva se utiliza para indicar a los robots de búsqueda que pueden rastrear e indexar una página o archivo específico.

- Disallow: Esta directiva se utiliza para indicar a los robots de búsqueda que no deben rastrear e indexar una página o archivo específico.

- Sitemap: Esta directiva se utiliza para indicar a los robots de búsqueda la ubicación del archivo Sitemap del sitio web.

Optimización del archivo robots.txt para SEO:

El archivo robots.txt puede ser utilizado para optimizar el SEO de un sitio web de las siguientes maneras:

- Evitar la indexación de contenido no deseado: El archivo robots.txt puede ser utilizado para evitar que los motores de búsqueda indexen contenido no deseado, como páginas de prueba, archivos de diseño o páginas con contenido duplicado.

- Priorizar el contenido importante: El archivo robots.txt puede ser utilizado para indicar a los robots de búsqueda qué páginas son las más importantes del sitio web, lo que les permite centrar sus recursos en el rastreo e indexación de estas páginas.

- Controlar el presupuesto de rastreo: El archivo robots.txt puede ser utilizado para controlar el número de páginas que los robots de búsqueda rastrean en un sitio web en un período determinado.

Mejores prácticas para la creación del archivo robots.txt:

- Probar el archivo robots.txt: Es importante probar el archivo robots.txt con la herramienta de prueba de robots.txt de Google para asegurarse de que funciona correctamente.

- Mantener el archivo robots.txt actualizado: El archivo robots.txt debe ser actualizado cada vez que se añaden o eliminan páginas del sitio web.

El archivo robots.txt es una herramienta poderosa que puede ser utilizada para optimizar el SEO de un sitio web. Al comprender cómo funciona el archivo robots.txt y cómo optimizarlo, los webmasters pueden mejorar la visibilidad de su sitio web en los resultados de búsqueda.

Recursos adicionales para la creación del archivo robots.txt: